ニュース

NVIDIA,次世代サーバー向けGPUアーキテクチャ「Blackwell」を発表。1パッケージに2基のGPUダイを搭載する巨大GPU

|

本稿では,NVIDIAの共同創業者兼CEOであるJensen Huang(ジェンスン・フアン)氏による基調講演を基に,Blackwellアーキテクチャの概要を紹介する。

Blackwellは,現行の「Hopper」アーキテクチャに続くもので,アーキテクチャの名称は,アフリカ系アメリカ人として初めて,全米科学アカデミー会員となった数学者・統計学者のDavid Harold Blackwell氏にちなんだものだという。

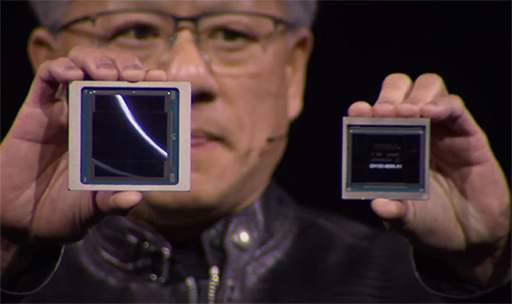

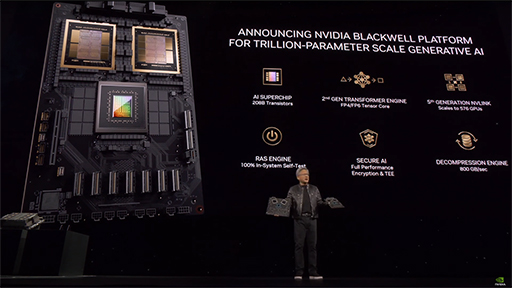

Huang氏は,AI技術の活用される場面が広がったことから,「現在は,とにかく大きなGPUが必要とされている」と述べる。そうした市場の要求に応えるべく,開発したのがMCMを採用したBlackwellアーキテクチャとB200だという。

もともと,NVIDIAは,とくにハイエンドモデルで大きなシリコンダイを用いる傾向にある。Hopper世代のスーパーコンピュータ向けGPU「H100」のダイサイズは,814mm2とかなりの大きさである。

|

B200で用いられる製造プロセスは,Hopper世代の「H100」で採用したTSMC 4Nの改良版となるTSMC 4NPで,プロセスノードはほぼ変わらない。つまり,ダイサイズを維持しつつ,トランジスタ数を増やすという手法は使えない。とはいえ,H100からさらにダイサイズを大きくすることも難しい。このような制約があるなかで,Huang氏がいう「とにかく大きなGPU」を実現するために,B200ではMCMを採用せざるを得なかったのだろう。

B200に搭載する2基のシリコンダイは,チップ上で10GB/sに達する広帯域リンクで結合されることで,1基のGPUとして振る舞う。チップ全体で集積するトランジスタ数は,2080億基とのことだ。

そんなB200チップ単体の性能は,AI処理の学習タスクに使用されるFP8(8bit浮動小数点演算)フォーマットの場合,H100の2倍である10 PFLOSに達する。

また,Blackwellアーキテクチャでは,第2世代の大規模言語モデル対応アクセラレータ「TensorRT-LLM」を搭載しており,推論に使用されるFP4(4bit浮動小数点演算)フォーマットをサポートするのも見どころだ。FP4の演算性能は20 PFLOSで,推論処理にかかる時間を高速化できると,Huang氏はアピールしていた。

GPU間を接続するインターコネクト「NVLink」も,第5世代へとバージョンアップして,1リンクあたり双方向で1.8TB/sの帯域幅へと広がった。この第5世代NVLinkをサポートするスイッチも新たに開発され,1つのNVLinkスイッチで最大72基のGPUを接続できる。加えて,NVLinkスイッチ同士を結合することで,最大576基のGPUを接続可能だ。

また,Blackwellアーキテクチャでは,データセンター向けの可用性やセキュリティの向上への取り組みも盛り込まれている。可用性の向上については,信頼性予測を行う「RAS Engine」を新たに組み込んだ。これにより,データセンターにおけるサーバーの診断情報を正確に取得可能で,ダウンタイムを最小に抑えられるという。

セキュリティでは,「NVIDIA Confidential Computing」と名付けられたハードウェアベースのセキュリティ機能を新たに搭載することで,GPUとして初めて「TEE-I/O」に対応したのがポイントだ。TEE-I/Oとは,「Intel Trust Domain Extensions」をベースにした入出力の仮想化技術で,暗号化を使ったセキュアなデータ転送を可能とする。NVIDIAによると,Blackwellアーキテクチャでは,ハードウェアの支援により,入出力データの暗号化を行った場合でも,暗号化しなかった場合と同じ処理性能を実現できるとのことだ。

|

そのほかにも,Blackwellアーキテクチャの新要素として,圧縮データの展開をハードウェアで行う「Decompression Engine」を搭載した点も挙げられよう。Decompression Engineは,LZ4やSnappy,Deflateといった圧縮フォーマットに対応するアクセラレータだ。この機能を利用することで,大量のデータを超高速でやりとりでき,GPUによるデータ解析の高性能化に威力を発揮するという。

B200を採用したスーパーコンピュータも披露

NVIDIAは,Hopper世代GPUのH100と,Armベースの独自CPU「Grace CPU」を1つのパッケージに収めた「Grace Hopper Superchip」や,そのGrace Hopper Superchipを用いたスーパーコンピュータを開発してきた。

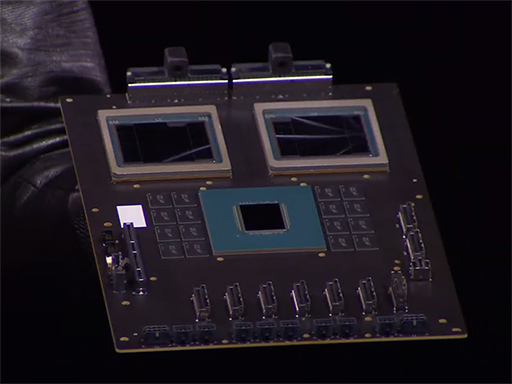

Blackwellアーキテクチャでも同じように,B200チップを中核としたシステム製品を同時に発表した。Grace Hopper Superchipの次世代製品にあたるのが,B200チップ2基とGrace CPUをNVLinkで結合した「GB200 Grace Blackwell Superchip」である。

|

|

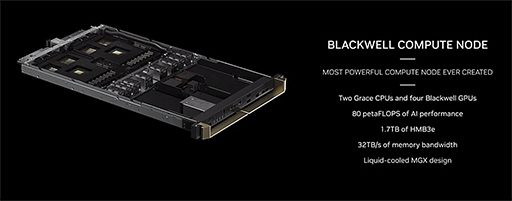

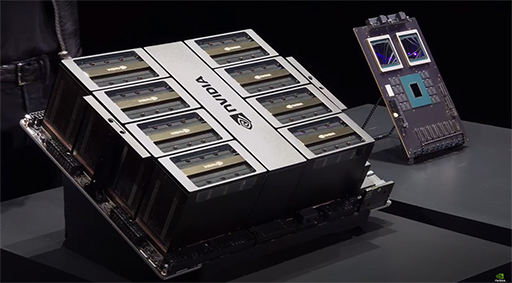

また,B200 Grace Blackwell Superchip×2基とNVLinkスイッチ×2基,通信モジュールを組み合わせたサーバー「Blackwell Compute Node」も用意。同製品をラックに18基収容した「GB200 NVL72」は,なんと1基で1.4 ExFLOPSの性能を発揮すると,Huang氏の鼻息も荒い。

|

|

1.4 ExFLOSに達するのは,FP8フォーマット使用時ということを割り引く必要はあるが,つい最近まで「エクサスケールが夢」と語られていたことを考えれば,なかなかに感慨深いものがある。Huang氏は,このGB200 NVL72で1兆パラメータのAIのトレーニングが可能と述べている。

ちなみに,GB200 NVL72は,液冷システムを想定しているのも見どころだ。データセンターは,いずれ液冷を導入することになると言われていたが,Blackwell世代でついにそれが現実となる。液冷は,物量が必要になるだけに,従来と比べてデータセンターの建設コストが上がるかもしれない。

そのほかに,B200を搭載する製品として,現行のHopperベースのスーパーコンピュータ「HGX H100」の後継モデルとなる次世代HGXも披露された。Huang氏によると,「世界中で使用されているHGX H100から,GPUモジュールを置き換えるだけで利用できる」とのことだ。

|

Blackwellは,ゲーマーに直接的に関係するGPUではないが,ゲームにおけるAI技術の活用はすでに始まっている。データセンターにおけるAI性能の向上は,ゲームにおけるAIの活用をさらに広げる原動力になるはずだ。

NVIDIAのBlackwellアーキテクチャ紹介ページ

NVIDIA公式Webサイト

- 関連タイトル:

Blackwell(開発コードネーム)

Blackwell(開発コードネーム)

- 関連タイトル:

Hopper(開発コードネーム)

Hopper(開発コードネーム) - この記事のURL: